Với Khoa CNTT, câu chuyện chatbot doanh nghiệp là một “phòng thí nghiệm sống” cho sinh viên và giảng viên: từ NLP, hệ thống truy vấn, kiến trúc RAG đến bảo mật và đánh giá mô hình. Với doanh nghiệp, những phân tích trong bài có thể là bước khởi đầu để chọn cách tiếp cận phù hợp với bối cảnh và nguồn lực của mình, trước khi đi tiếp sang các thiết kế chi tiết hơn về RAG và các biến thể nâng cao ở những bài viết kế tiếp.

- Đặt vấn đề

Trong vài năm gần đây, làn sóng trí tuệ nhân tạo (AI) – đặc biệt là AI tạo sinh (Generative AI) và các mô hình ngôn ngữ lớn (LLM) như GPT, LLaMA, Claude… – đã đi từ phòng thí nghiệm ra đời sống rất nhanh. Không chỉ các tập đoàn công nghệ, mà cả ngân hàng, bán lẻ, logistics, giáo dục, y tế… đều bắt đầu nói về việc ứng dụng AI để tối ưu quy trình, giảm chi phí vận hành và tạo ra trải nghiệm mới cho khách hàng. Ở Việt Nam, nhiều doanh nghiệp cũng đã “thử sức” với các sản phẩm như chatbot tư vấn, trợ lý ảo, tổng đài thông minh, hệ thống gợi ý… như một phần của chiến lược chuyển đổi số.

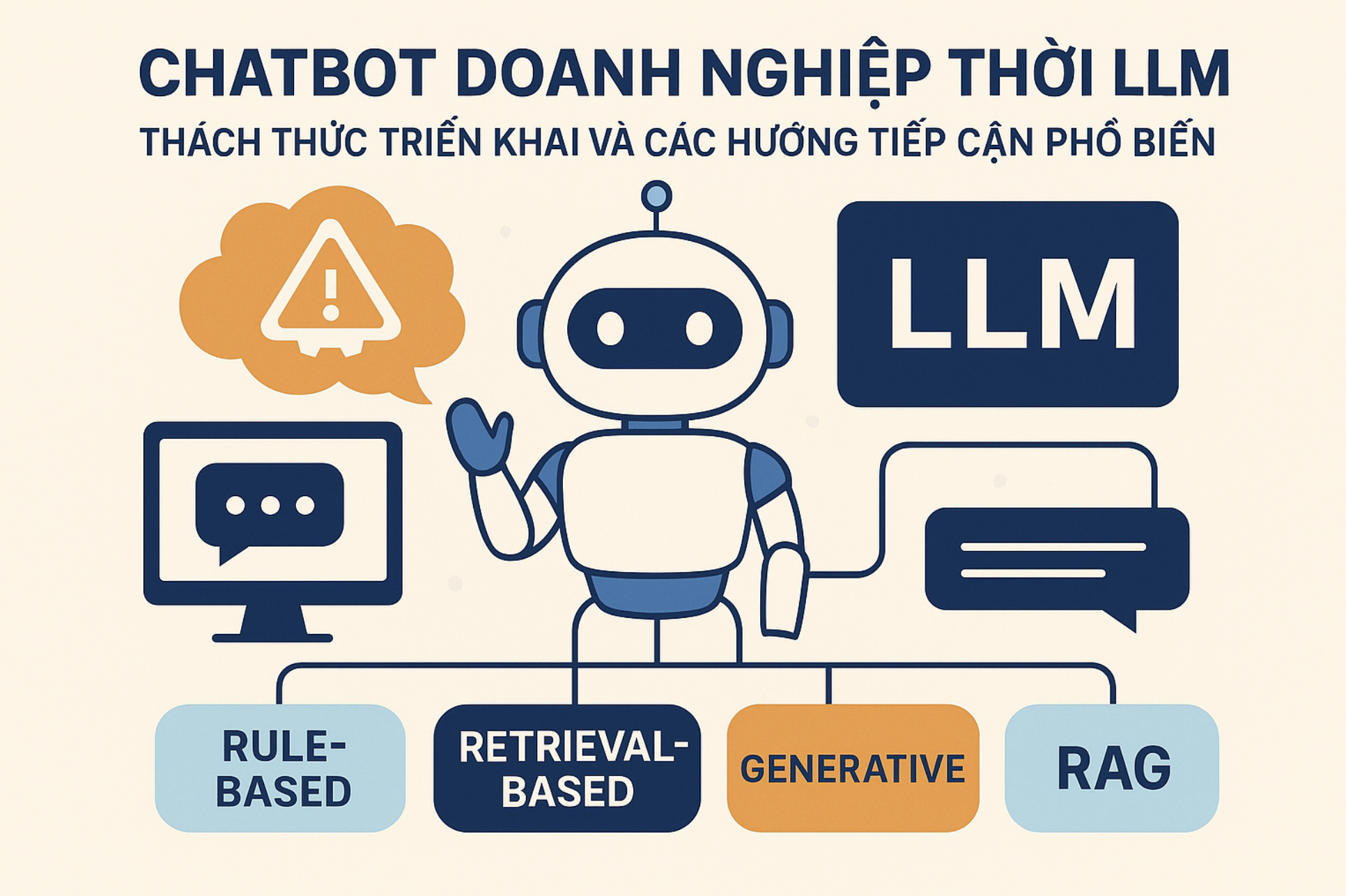

Hình 1 Minh họa Chatbot doanh nghiệp – Ảnh: ChatGPT

Trong bức tranh đó, chatbot và trợ lý hội thoại thông minh trở thành một trong những ứng dụng phổ biến nhất. Từ góc nhìn doanh nghiệp, một chatbot “lý tưởng” có thể làm được rất nhiều việc:

- Tư vấn khách hàng 24/7, giảm tải cho đội ngũ chăm sóc khách hàng.

- Trả lời nhanh các câu hỏi lặp lại về sản phẩm, chính sách, quy trình.

- Hỗ trợ nhân sự nội bộ tra cứu quy chế, biểu mẫu, hướng dẫn công việc.

- Ghi nhận phản hồi, khiếu nại, góp ý để lãnh đạo có dữ liệu ra quyết định.

So với các kênh truyền thống (email, điện thoại, form liên hệ), một chatbot được thiết kế tốt có thể rút ngắn thời gian phản hồi, nâng cao mức độ hài lòng của người dùng, đồng thời giúp doanh nghiệp tiết kiệm chi phí vận hành. Đây là lý do khiến nhiều báo cáo quốc tế đều xem “AI cho chăm sóc khách hàng và hỗ trợ vận hành” là những case study phổ biến và dễ thấy hiệu quả nhất.

Tuy nhiên, nếu nhìn kỹ vào thực tế triển khai tại nhiều tổ chức, chúng ta sẽ thấy một khoảng cách khá lớn giữa kỳ vọng về chatbot “thông minh như con người” và trải nghiệm thực tế của người dùng. Không ít doanh nghiệp đã từng đầu tư một “chatbot” trên website, nhưng:

- Chatbot chỉ trả lời được những câu hỏi rất đơn giản, đúng theo kịch bản đã được lập trình cứng.

- Người dùng hỏi hơi khác câu chữ đã định là chatbot “bó tay”, trả lời vòng vo hoặc chuyển sang nhân viên.

- Hệ thống gần như không học được gì thêm từ dữ liệu thực tế, không thích nghi với sản phẩm, chính sách, quy trình luôn thay đổi của doanh nghiệp.

Ở chiều ngược lại, các mô hình LLM thế hệ mới (như ChatGPT) cho thấy khả năng hiểu ngữ cảnh, đối thoại tự nhiên, diễn giải trôi chảy rất ấn tượng. Điều này khiến nhiều người đặt câu hỏi: “Nếu ChatGPT trả lời được gần như mọi thứ, tại sao không dùng luôn nó làm chatbot doanh nghiệp?”

Câu trả lời không đơn giản. Với môi trường doanh nghiệp, các yêu cầu về bảo mật dữ liệu, quyền riêng tư, kiểm soát nội dung và tính đúng đắn thông tin là vô cùng khắt khe. Một chatbot doanh nghiệp không chỉ cần “nói cho hay”, mà phải trả lời dựa trên các tài liệu nội bộ, quy định, quy trình chính thức; nếu cung cấp thông tin sai lệch về hợp đồng, chính sách, lãi suất, pháp lý… thì rủi ro không chỉ là trải nghiệm người dùng mà còn là uy tín và trách nhiệm pháp lý của tổ chức.

Thực tế đó đặt ra hai nhóm bài toán cho doanh nghiệp và đội ngũ kỹ sư AI:

- Về mặt kỹ thuật: làm sao để tận dụng được sức mạnh của LLM (khả năng hiểu và sinh ngôn ngữ tự nhiên), nhưng vẫn cho mô hình “nói” dựa trên dữ liệu thật của doanh nghiệp, thay vì bịa thêm? Làm sao kết nối tri thức nội bộ (tài liệu, văn bản, email, quyết định, quy trình…) với mô hình một cách an toàn và hiệu quả?

- Về mặt nguồn lực: không phải doanh nghiệp nào cũng có đủ hạ tầng tính toán, dữ liệu đã được chuẩn hóa và đội ngũ chuyên gia để tự huấn luyện hoặc fine-tune một mô hình ngôn ngữ lớn cho riêng mình.

Chính vì vậy, câu chuyện “Ứng dụng AI trong doanh nghiệp” không chỉ là mua một mô hình mạnh, cài đặt một chatbot lên website và hy vọng mọi thứ sẽ tự chạy. Đằng sau một chatbot doanh nghiệp hoạt động hiệu quả là cả một kiến trúc kỹ thuật và một cách tiếp cận bài bản: từ việc xây dựng kho dữ liệu, thiết kế pipeline truy xuất – xử lý – tổng hợp thông tin, đến việc theo dõi, đánh giá và điều chỉnh mô hình trong quá trình vận hành.

Bài viết này được xây dựng trong bối cảnh đó, với mục tiêu giúp sinh viên, giảng viên và doanh nghiệp đối tác của Khoa CNTT có cái nhìn rõ hơn về:

- Vì sao việc tạo chatbot doanh nghiệp “thật sự hiểu dữ liệu nội bộ” lại khó.

- Các kỹ thuật đang được sử dụng để xây dựng chatbot, từ rule-based truyền thống đến các mô hình sử dụng LLM.

- Và đặc biệt là cách tiếp cận Retrieval-Augmented Generation (RAG) – một xu thế đang nổi bật trong việc xây dựng assistant và chatbot thông minh cho doanh nghiệp.

Trong phần tiếp theo, chúng ta sẽ đi vào các khó khăn cụ thể khi tạo chatbot doanh nghiệp, từ hạn chế của LLM cho đến bài toán phần cứng và dữ liệu, để thấy rõ hơn “nút thắt” mà RAG đang cố gắng tháo gỡ.

- Những khó khăn khi xây dựng chatbot cho doanh nghiệp

Nếu chỉ nhìn vào các demo ấn tượng của ChatGPT hay các mô hình tương tự, nhiều người có cảm giác rằng việc xây dựng một chatbot “biết tuốt” cho doanh nghiệp là chuyện đơn giản: chỉ cần kết nối API, viết thêm vài dòng code là xong. Nhưng khi bắt tay vào triển khai thực tế, đặc biệt trong môi trường có nhiều ràng buộc như ngân hàng, bảo hiểm, cơ quan nhà nước, trường đại học…, đội ngũ kỹ sư mới thấy bài toán phức tạp hơn rất nhiều.

Dưới đây là ba nhóm khó khăn lớn thường gặp khi xây dựng chatbot doanh nghiệp.

2.1. Hạn chế cố hữu của mô hình ngôn ngữ lớn (LLM)

Mặc dù LLM có khả năng hiểu và sinh ngôn ngữ tự nhiên rất ấn tượng, nhưng nếu dùng “thuần” LLM để trả lời cho doanh nghiệp, chúng ta phải đối mặt với nhiều vấn đề:

(1) Hallucination – mô hình “tự bịa”

LLM được huấn luyện trên dữ liệu tổng hợp từ internet, sách báo, tài liệu công khai… Mô hình học được xác suất xuất hiện của các chuỗi từ, chứ không “hiểu” khái niệm đúng/sai như con người. Khi được hỏi về một nội dung không có trong dữ liệu huấn luyện, LLM vẫn có thể tạo ra câu trả lời trôi chảy nhưng không chính xác, hoặc thậm chí hoàn toàn bịa đặt.

Trong bối cảnh doanh nghiệp, những “sáng tạo” kiểu này có thể dẫn đến:

- Tư vấn sai về lãi suất, phí phạt, điều khoản hợp đồng.

- Diễn giải nhầm quy định pháp lý, quy chế nội bộ.

- Gây hiểu lầm cho khách hàng về quyền lợi, nghĩa vụ, thời hạn bảo hành…

(2) Thiếu tri thức nội bộ và tính cập nhật

LLM không “biết sẵn” tài liệu nội bộ của doanh nghiệp: quy chế, quy trình, tài liệu đào tạo, biên bản họp, email, quyết định… Nếu chỉ gọi API mà không có cơ chế kết nối với kho tri thức nội bộ, chatbot sẽ chỉ trả lời dựa trên kiến thức chung, không phản ánh đúng “ngôn ngữ doanh nghiệp”.

Ngoài ra, tri thức doanh nghiệp luôn thay đổi: sản phẩm mới, chính sách mới, cơ cấu tổ chức mới… Trong khi đó, một mô hình LLM sau khi huấn luyện xong thì “đóng băng” tại thời điểm đó. Việc cập nhật kiến thức mới không hề đơn giản.

(3) Khó kiểm soát nội dung và phong cách trả lời

Doanh nghiệp thường cần:

- Cách diễn đạt thống nhất với bộ nhận diện thương hiệu.

- Hạn chế các câu trả lời mang tính suy đoán, thể hiện quan điểm cá nhân, hoặc “đùa cợt” quá mức.

- Tuân thủ quy định nội bộ về phát ngôn, bảo mật thông tin, đạo đức nghề nghiệp.

Nếu chỉ dựa vào một prompt chung, rất khó đảm bảo chatbot luôn trả lời đúng “tone & manner” mong muốn, đặc biệt trong các tình huống nhạy cảm (khiếu nại, tranh chấp, cố sự cố…).

2.2. Thách thức về hạ tầng tính toán và dữ liệu khi huấn luyện/fine-tune

Một hướng tiếp cận thường được đề xuất là: “fine-tune một LLM riêng cho doanh nghiệp”. Nghe có vẻ hợp lý, nhưng khi triển khai thực tế, các rào cản sau xuất hiện:

(1) Chi phí phần cứng và hạ tầng

- Huấn luyện hoặc fine-tune LLM đòi hỏi GPU có VRAM lớn, cụm máy chủ, hệ thống lưu trữ và mạng ổn định.

- Với các mô hình hàng tỷ tham số, chi phí này là một con số đáng kể, đặc biệt với doanh nghiệp vừa và nhỏ hoặc tổ chức công.

- Ngoài phần cứng, còn chi phí triển khai, giám sát, backup, nâng cấp… – không phải tổ chức nào cũng sẵn sàng đầu tư.

(2) Dữ liệu nội bộ chưa “sẵn sàng” cho học máy

Đa số doanh nghiệp không có một “data lake sạch đẹp” như trong sách giáo trình:

- Tài liệu nằm rải rác trong file Word, PDF, email, hệ thống quản lý văn bản, các phần mềm khác nhau.

- Nhiều tài liệu không được chuẩn hóa, thiếu metadata (ngày ban hành, người phụ trách, trạng thái hiệu lực…).

- Dữ liệu có thể chứa thông tin nhạy cảm, trùng lặp, thậm chí mâu thuẫn giữa các phiên bản.

Để dùng dữ liệu này cho huấn luyện/fine-tune, cần một quy trình dài: thu thập – làm sạch – chuẩn hóa – phân loại – gắn nhãn – lọc thông tin nhạy cảm… Đây là công việc tốn rất nhiều thời gian và nguồn lực.

(3) Thiếu đội ngũ chuyên gia AI chuyên sâu

Huấn luyện/fine-tune một LLM không chỉ là vấn đề “chạy code” mà cần:

- Kỹ sư ML/AI hiểu rõ kiến trúc mô hình, chiến lược tối ưu, regularization, đánh giá…

- DevOps/MLOps để triển khai, giám sát, rollback khi có sự cố.

- Chuyên gia nghiệp vụ để thiết kế dữ liệu huấn luyện và đánh giá chất lượng đáp án.

Không phải doanh nghiệp nào cũng có đội ngũ như vậy. Việc phụ thuộc hoàn toàn vào nhà cung cấp bên ngoài cũng tiềm ẩn nhiều rủi ro về chi phí và kiểm soát.

2.3. Bảo mật, quyền riêng tư và tuân thủ pháp lý

Trong môi trường doanh nghiệp, đặc biệt là các ngành tài chính, y tế, giáo dục, cơ quan nhà nước, dữ liệu không chỉ là tài sản mà còn là trách nhiệm pháp lý. Khi xây dựng chatbot, các câu hỏi sau luôn xuất hiện:

- Dữ liệu nào được phép đưa vào hệ thống để chatbot “học” và trả lời?

- Có thông tin cá nhân (PII)?

- Có dữ liệu nhạy cảm như hồ sơ bệnh án, thông tin tài chính, hợp đồng, quyết định nội bộ?

- Dữ liệu được xử lý và lưu trữ ở đâu?

- Trên hạ tầng nội bộ (on-premise) hay trên cloud?

- Có tuân thủ các quy định về bảo vệ dữ liệu cá nhân, an toàn thông tin, lưu trữ hồ sơ không?

- Mô hình có “vô tình rò rỉ” thông tin ra ngoài không?

- Nếu dùng API LLM từ bên thứ ba, dữ liệu truy vấn có thể được sử dụng để cải thiện mô hình tổng quát, hoặc bị ghi log.

- Điều này có thể mâu thuẫn với yêu cầu bảo mật của doanh nghiệp hoặc quy định pháp luật.

Bên cạnh đó, việc chatbot trả lời sai về các vấn đề pháp lý, tài chính, nhân sự… có thể tạo ra rủi ro về trách nhiệm giải trình: ai chịu trách nhiệm cho câu trả lời của chatbot – nhà cung cấp mô hình, doanh nghiệp hay người triển khai?

Tóm lại, việc xây dựng chatbot cho doanh nghiệp không chỉ là câu chuyện của một mô hình AI mạnh, mà là bài toán tổng hợp giữa năng lực của LLM, hạ tầng và dữ liệu nội bộ, cùng với yêu cầu bảo mật – pháp lý – vận hành của từng tổ chức. Chính những khó khăn này đã thúc đẩy cộng đồng nghiên cứu và doanh nghiệp tìm kiếm những cách tiếp cận “thực tế hơn” – trong đó Retrieval-Augmented Generation (RAG) nổi lên như một lựa chọn cân bằng giữa sức mạnh của LLM và khả năng kiểm soát tri thức nội bộ.

Ở phần tiếp theo, chúng ta sẽ cùng nhìn lại các kỹ thuật phổ biến để xây dựng chatbot – từ rule-based, retrieval thuần túy đến generative – trước khi đi sâu vào RAG như một bước tiến quan trọng trong kiến trúc chatbot doanh nghiệp hiện đại.

- Các cách tiếp cận phổ biến khi xây dựng chatbot

Trước khi đi sâu vào RAG, sẽ dễ hình dung hơn nếu chúng ta đặt RAG bên cạnh những “trường phái” xây dựng chatbot đã và đang được dùng trong thực tế. Ở mức khái quát, có bốn cách tiếp cận chính:

- Chatbot rule-based (dựa trên kịch bản/quy tắc).

- Chatbot retrieval-based (dựa trên tìm kiếm trong kho tri thức).

- Chatbot generative (dựa trên mô hình ngôn ngữ – LLM).

- Chatbot RAG – kết hợp retrieval và generative.

Mỗi cách tiếp cận có “tính cách” riêng: có loại rất dễ kiểm soát nhưng cứng nhắc, có loại rất thông minh nhưng khó quản lý nội dung, có loại là sự dung hòa nằm ở giữa.

3.1. Chatbot rule-based – “kịch bản cứng”

Đây là thế hệ chatbot xuất hiện sớm nhất và vẫn còn hiện diện rất nhiều trong thực tế.

Nguyên lý hoạt động

- Lập trình viên hoặc chuyên viên nghiệp vụ thiết kế trước các kịch bản hội thoại:

- Nếu người dùng chọn A → trả lời X, chuyển sang bước 2.

- Nếu người dùng chọn B → trả lời Y, kết thúc.

- Người dùng tương tác qua các menu, nút bấm, từ khóa cố định (Ví dụ: 1 – Tư vấn sản phẩm, 2 – Kiểm tra đơn hàng, 3 – Gặp nhân viên…).

- Phần “thông minh” chủ yếu nằm ở logic rẽ nhánh (cây quyết định) chứ không phải ở khả năng hiểu ngôn ngữ tự nhiên.

Ưu điểm

- Dễ triển khai, chi phí thấp, không nhất thiết phải dùng AI.

- Nội dung trả lời rất dễ kiểm soát: chỉ nói đúng những gì đã được phê duyệt trong kịch bản.

- Phù hợp với quy trình đơn giản, ít tình huống, yêu cầu tuân thủ chặt chẽ (ví dụ: trả lời về giờ làm việc, bảng giá cố định, địa chỉ chi nhánh…).

Hạn chế

- Cứng nhắc: người dùng hỏi lệch khỏi kịch bản là chatbot “bí”, thường chỉ biết trả lời “Em chưa hiểu câu hỏi của anh/chị” hoặc đề nghị gọi tổng đài.

- Khó mở rộng khi số lượng kịch bản tăng: thêm mỗi trường hợp mới lại phải chỉnh sửa logic, dễ tạo ra “mạng nhện” khó bảo trì.

- Không hiểu ngôn ngữ tự nhiên, không nhớ ngữ cảnh trò chuyện nhiều lượt.

Khi nào phù hợp?

- Doanh nghiệp chỉ cần một chatbot hỏi–đáp đơn giản hoặc menu điều hướng.

- Nguồn lực kỹ thuật hạn chế, chưa sẵn sàng đầu tư vào AI nhưng muốn có bước đầu tự động hóa.

3.2. Chatbot retrieval-based – “tìm câu trả lời trong kho tri thức”

Khi dữ liệu doanh nghiệp được số hóa tốt hơn, nhu cầu “tra cứu thông tin” tăng lên, chatbot retrieval-based trở thành một bước tiến so với rule-based.

Nguyên lý hoạt động

- Doanh nghiệp xây dựng kho tri thức (knowledge base): câu hỏi thường gặp (FAQ), tài liệu hướng dẫn, quy định, bài viết hỗ trợ…

- Khi người dùng đặt câu hỏi, hệ thống sẽ:

- Biến câu hỏi thành truy vấn tìm kiếm.

- Dùng các kỹ thuật tìm kiếm từ khóa (keyword search) hoặc tìm kiếm ngữ nghĩa (semantic search) để tìm câu trả lời/câu tương ứng trong kho tri thức.

- Trả lại cho người dùng câu trả lời đã có sẵn (hoặc đoạn văn gần nhất).

Về bản chất, đây là việc “gói một công cụ tìm kiếm thân thiện trong giao diện chat”.

Ưu điểm

- Chatbot trả lời dựa trên nội dung có thật trong kho dữ liệu, dễ kiểm tra, dễ gắn link nguồn.

- Kiểm soát nội dung tốt: vì câu trả lời được soạn trước và lưu trong hệ thống.

- Cập nhật tri thức tương đối dễ: chỉ cần thêm/sửa tài liệu hoặc FAQ, không phải huấn luyện lại mô hình.

- Nếu dùng tốt semantic search, chatbot có thể xử lý được những câu hỏi không trùng khớp 100% câu chữ với dữ liệu gốc.

Hạn chế

- Phụ thuộc mạnh vào chất lượng kho tri thức và thuật toán truy xuất:

- Nếu dữ liệu lộn xộn, tài liệu mâu thuẫn, câu trả lời cũng dễ gây nhầm lẫn.

- Nếu thuật toán tìm kiếm yếu, chatbot có thể trả về nội dung không đúng trọng tâm, dù vẫn là “dữ liệu thật”.

- Khó xử lý các câu hỏi dài, nhiều ngữ cảnh hoặc câu hỏi cần tổng hợp từ nhiều nguồn thông tin khác nhau.

- Câu trả lời thường mang tính “nguyên văn”, ít tùy biến theo phong cách giao tiếp, hoàn cảnh cụ thể.

Khi nào phù hợp?

- Doanh nghiệp có kho FAQ và tài liệu tương đối chuẩn hóa, muốn dựng nhanh một chatbot hỗ trợ tra cứu.

- Các bài toán như: tra cứu quy chế nội bộ, hướng dẫn sử dụng sản phẩm, tài liệu kỹ thuật, thủ tục hành chính…

3.3. Chatbot generative – “trợ lý trò chuyện dựa trên LLM”

Sự xuất hiện của các mô hình ngôn ngữ lớn (LLM) đã đưa chatbot lên một “đẳng cấp” mới.

Nguyên lý hoạt động

- Thay vì trả lời bằng câu chữ được viết sẵn, chatbot sử dụng LLM (như GPT, LLaMA…) để sinh ra câu trả lời mới dựa trên câu hỏi và ngữ cảnh hội thoại.

- Mô hình có khả năng:

- Hiểu câu hỏi được diễn đạt theo nhiều kiểu ngôn ngữ khác nhau.

- Ghi nhớ ngữ cảnh nhiều lượt, phản hồi tự nhiên, có tính “hội thoại” hơn.

- Diễn giải, tóm tắt, giải thích, sáng tạo nội dung ở nhiều dạng.

Trong thực tế, có hai hướng phổ biến:

- Dùng thẳng LLM “thuần” (hoặc với chút prompt engineering) như một trợ lý tổng quát.

- Fine-tune LLM trên dữ liệu riêng của doanh nghiệp (trong phạm vi cho phép) để mô hình “quen” với ngôn ngữ, phong cách, miền tri thức cụ thể.

Ưu điểm

- Linh hoạt và tự nhiên trong hội thoại: xử lý được câu hỏi phức tạp, chưa từng xuất hiện, có ngữ cảnh dài.

- Có thể tổng hợp thông tin từ nhiều nguồn tri thức khác nhau (đã được mô hình “học” trong quá trình huấn luyện).

- Phù hợp cho các use case như: trợ lý học tập, trợ lý lập trình, gợi ý nội dung marketing, viết email, tóm tắt tài liệu…

Hạn chế

- Vấn đề hallucination: mô hình có thể sinh ra câu trả lời trôi chảy nhưng không chính xác.

- Thiếu “tri thức nội bộ” nếu không được kết nối với dữ liệu doanh nghiệp (như đã phân tích ở phần 2).

- Việc fine-tune hoặc triển khai LLM riêng cho doanh nghiệp đòi hỏi chi phí phần cứng, dữ liệu và nhân sự không nhỏ.

- Khó kiểm soát 100% nội dung: cần thiết kế thêm các lớp kiểm duyệt (guardrail), policy, logging… để đảm bảo an toàn.

3.4. RAG – kết hợp sức mạnh của retrieval và generative

Retrieval-Augmented Generation (RAG) xuất hiện như một cách tiếp cận “dung hòa”:

- Vẫn tận dụng được khả năng hiểu và sinh ngôn ngữ tự nhiên rất mạnh của LLM.

- Đồng thời neo câu trả lời vào dữ liệu thật của doanh nghiệp thông qua một lớp truy xuất (retrieval) phía trước.

Ý tưởng cốt lõi

- Khi người dùng đặt câu hỏi, hệ thống truy xuất (retrieve) các đoạn tài liệu liên quan từ kho dữ liệu nội bộ (FAQ, PDF, văn bản, wiki…).

- Các đoạn tài liệu này được đưa vào cùng với câu hỏi để tạo thành một prompt giàu ngữ cảnh cho LLM.

- LLM sinh câu trả lời dựa trên ngữ cảnh đó, thay vì chỉ dựa vào “trí nhớ” bên trong mô hình.

Như vậy, LLM đóng vai trò như một “bộ máy diễn giải và tổng hợp”, còn tri thức thực tế thì đến từ kho dữ liệu được truy xuất động.

Ưu điểm (ở góc độ tổng quan)

- Giảm đáng kể hiện tượng bịa: vì câu trả lời được “neo” vào đoạn tài liệu cụ thể, có thể gắn link hoặc trích dẫn.

- Cập nhật tri thức dễ hơn: chỉ cần thêm/sửa dữ liệu trong kho, không phải huấn luyện lại LLM.

- Giúp chatbot vừa hiểu câu hỏi tự nhiên, vừa trả lời dựa trên quy định/tài liệu chính thức của doanh nghiệp.

Hạn chế

- Cần xây dựng một pipeline tương đối hoàn chỉnh: thu thập – làm sạch – phân mảnh (chunking) – indexing – truy xuất tài liệu.

- Chất lượng câu trả lời phụ thuộc nhiều vào chất lượng truy xuất: nếu truy xuất sai hoặc thiếu, LLM cũng khó trả lời đúng.

- Vẫn cần các cơ chế kiểm soát nội dung (guardrail, policy) và giám sát hiệu năng.

3.5. So sánh nhanh các cách tiếp cận

Bảng dưới đây tóm tắt một số khác biệt chính giữa bốn “trường phái” chatbot nói trên (mức độ chỉ mang tính tương đối):

| Cách tiếp cận | Nguyên lý chính | Linh hoạt hội thoại | Kiểm soát nội dung | Phụ thuộc dữ liệu nội bộ | Chi phí triển khai tương đối | Phù hợp cho… |

| Rule-based | Kịch bản, cây quyết định, IF–THEN | Thấp | Rất cao | Thấp | Thấp | Quy trình đơn giản, FAQ cố định |

| Retrieval-based | Tìm câu trả lời trong kho tri thức | Trung bình | Cao | Trung bình – Cao | Thấp – Trung bình | Tra cứu tài liệu, FAQ, hướng dẫn |

| Generative (LLM) | LLM sinh câu trả lời mới từ prompt | Rất cao | Trung bình | Thấp (nếu không nối dữ liệu) | Trung bình – Cao | Trợ lý tổng quát, sáng tạo nội dung |

| RAG | Retrieval + LLM, sinh trả lời từ tài liệu đã truy xuất | Cao | Cao (nếu dữ liệu tốt) | Cao | Trung bình | Chatbot doanh nghiệp, trợ lý tri thức |

Từ bảng so sánh này, có thể thấy RAG không phải “thần dược”, nhưng là một điểm cân bằng hợp lý giữa:

- Tính linh hoạt của LLM,

- Khả năng kiểm soát và cập nhật tri thức,

- Chi phí và độ phức tạp triển khai.

- Kết luận

Đằng sau một chatbot hoạt động trơn tru trong doanh nghiệp không chỉ là vài dòng “gọi API LLM”, mà là cả bài toán kiến trúc hệ thống và quản trị tri thức nội bộ. Những hạn chế cố hữu của LLM (hallucination, thiếu dữ liệu nội bộ, khó kiểm soát nội dung), cùng rào cản về hạ tầng, dữ liệu và nhân sự, khiến việc “làm chatbot” trở thành một dự án nghiêm túc, cần được thiết kế ngay từ đầu chứ không chỉ là trào lưu.

Bốn hướng tiếp cận phổ biến – rule-based, retrieval-based, generative và RAG – thể hiện các mức độ đánh đổi khác nhau giữa tính linh hoạt, khả năng kiểm soát và chi phí vận hành. Trong đó, RAG nổi lên như một lựa chọn cân bằng: tận dụng được sức mạnh LLM, nhưng vẫn “neo” được câu trả lời vào dữ liệu thật của tổ chức.

ThS. Trần Châu Thanh thiện – Bộ môn Trí tuệ nhân tạo

fit@ntt.edu.vn

fit@ntt.edu.vn 028 71080889

028 71080889